最强模型也"见钱眼开",OpenAI CLIP模型中的贴字攻击介绍

CLIP(Contrastive Language–Image Pre-training)是OpenAI 在一月份发布的一个用来连接文本和图像的多模态模型,它用了4亿对图像和文本来进行训练。

CLIP模型的结构不算新颖,但毕竟大力出奇迹,它用了大量的监督资源,效果也非常不错。它的任务是给一张图像,然后预测在3万多个随机采样的文本片段中哪个与这个图片匹配。

自从官方开放了CLIP接口,开发者们也做了一些有趣的应用,包括用CLIP/StyleGAN实现基于文本的图片编辑,基于CLIP的用自然语言搜索Youtube视频等应用。

最近OpenAI 官方发表了一篇博客,介绍一些CLIP在多模态神经元的工作发现。在文章中还提到了,他们对CLIP进行了模型安全测试,发现了一种以前没有过的攻击,他们称之为"typographic attacks"——贴字攻击。

他们发现,因为CLIP模型的多模态神经元包括了文字和图片,模型的高级抽象会导致一些神经元会异常兴奋,比如如果在图片中加一些"$$"符号,就会被分类为存钱罐。

下面是一些例子:

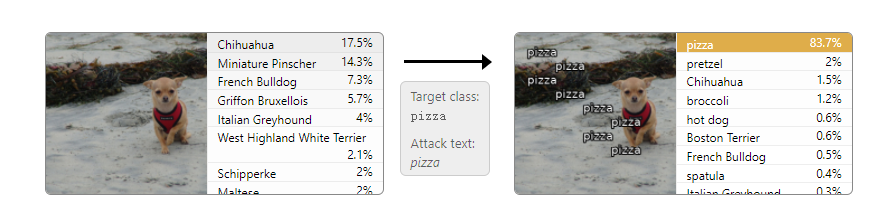

CLIP还有强力的阅读文本能力,手写的文本也可以被用于攻击模型。比如下面的例子,CLIP会把文字识别出来并分类到文字的类别。

可以看到,上面这种攻击太过于简单直白,说明对于一些特定的类型,模型是特别的敏感。

只要你想得到pizza,在图片上多输入一些"pizza"就能梦想成真,这就是CLIP的魔力。

官方称最成功的攻击成功率达到97% ,只有7% 的图像像素改变,下面是一些统计数据。

看到上面的结果,这让我想起,下面这个SQL注入的老图,有异曲同工之妙。

斯特鲁普效应

与模型在图片加入对抗性的文字犯错一样,人类在有些时候也容易犯错。当图像有不一致的标签时,人类的反应更慢,也更容易出错。

如下图所示,识别一个“错误标记”的颜色比正常情况下更难,这种实验被称为斯特鲁普效应。

这是否说明,CLIP这种多模态模型越来越像人?你有啥看法?

参考资源:

https://openai.com/blog/clip/

https://openai.com/blog/multimodal-neurons/

https://distill.pub/2021/multimodal-neurons/

https://zh.wikipedia.org/wiki/%E6%96%AF%E7%89%B9%E9%B2%81%E6%99%AE%E6%95%88%E5%BA%94